决策树是一种非常简单的机器学习模型,可视化通用树结构是一种相当成熟的技术。然而,决策树可能变得非常大,限制了简单技术的实用性。典型的可视化环境,如Weka的默认实现GraphViz,可以生成树的大小,使它们难以呈现、导航或解释。

树木拥抱吗?

在Bibeplay2网页登陆gML,我们给予决策树一些爱,并使可视化成为我们模型分析工作流的一流公民。以下是我们可视化功能的一些亮点:

#1修剪并挤压

决策树可视化布局使用一种算法,生成树的紧凑表示,基于工作Reingold,蒂尔福德,布赫海姆.

此布局非常适合防止树变得太宽,同时使每个分支(或“节点”)都能清晰显示。但是,即使布局紧凑,树仍然太宽,无法在普通浏览器上显示。因此,我们只显示树中至少有1%的部分新闻报道(我们允许你看到更多/更少的分支和互动浏览,稍后会详细介绍)。由于树的许多分支只看到训练数据的一小部分,它们通常与模型不相关或不可靠。我们将这个数据覆盖率编码为每个分支线的宽度,因此您可以快速查看树的哪些部分覆盖了训练数据的更大部分。因此,树顶的线条往往比树底的线条更宽。

#2油漆和标签

树结构本身不足以真正了解有关模型的任何有用信息。有用的信息可能包括给定分支用于做出分支决策的字段/信息。了解导致特定预测的决策也很有用。一种常见的可视化方法(如前面所示的Weka示例)是显示此信息在这棵树。这有几个缺点,包括引起易读性问题、溢出问题和一般信息过载问题。

而不是将信息嵌入可视化本身,我们选择将相关的模型信息沿着一边的模型。

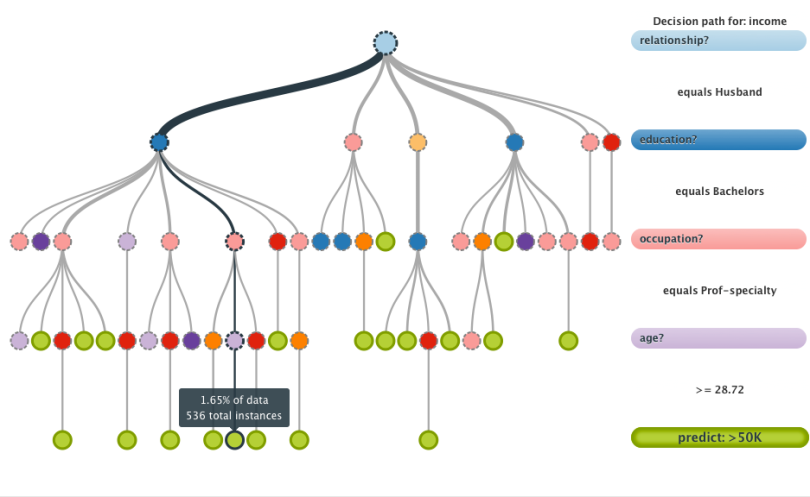

树现在有了代表分支使用的不同字段的颜色。右边字段的颜色将与当前突出显示的路径的颜色匹配。这使得识别整个树中经常出现的重要字段变得很容易。我们使用绿色的BigML标beplay2网页登陆志颜色作为“预测”节点。

无论何时高亮显示树中的路径(以较粗、较暗的线显示),相应的路径信息都会显示在右侧。例如,该模型评估个人的人口普查信息。它首先关注的是关系状态。在当前分支中,这等于“丈夫”。接下来,它将评估教育、职业和年龄。从上到下阅读,很容易看到决策树用来得出给定预测的一系列问题和答案(在本例中,预测他们的年收入是否超过5万美元)。一个较小的弹出窗口告诉您数据新闻报道对于给定的节点,以百分比或计数表示。

这种方法允许用户从字段中的文本信息中清楚地看到树的结构形式。由于文本信息都在一列中,因此更容易理解用一系列简单的问题和答案表示的整个预测路径。

#3滑动、指向并单击

决策树布局函数默认使用剪枝方法,可以隐藏某些分支。当一个分支被隐藏时,父分支将有一个破碎的轮廓,表明它包含一个或多个隐藏的子分支。单击父节点将显示它在流体动画中包含的所有子节点。

通过这种方式,很容易访问任何被剪枝方法隐藏的数据覆盖率低的分支。

剪枝方法本身(称为“实时剪枝”)允许您以极大的粒度更改数据覆盖率剪枝,并立即看到新的可视化表示。可以通过将模型控制栏上的“实时修剪”控件向左或向右滑动来执行此操作。

通过这种方式,很容易“调优”决策树,以显示数据覆盖率最低阈值较高的节点。

#4个实时更新

我们的决策树训练算法适用于任何大小的数据。然而,大型数据集的模型训练不是瞬时的。因此,我们的决策树可视化屏幕共享定期更新自己,以显示部分训练的决策树的当前状态。这种方法对于获得关于模型如何解释数据的即时反馈非常有用,允许我们的用户能够在错误指定的模型完成之前取消它,而不是等待。

想看看它的实际行动吗?

注册一个beplay2网页登陆BigML帐户,并准备好以全新的视角来看待决策树。你有决策树的经验吗?爱他们,恨他们,或者只是好奇?请在下方留言。

据我所知,使用决策树的主要原因不是因为它们的预测能力,而是当试图提取模式时。

例如,如果你试图预测客户愿意为你的产品支付多少钱:

那么你真正想知道的是哪一个领域对预测的影响最大,以及它们对预测的影响是消极的还是积极的。

在这种情况下,我发现比决策树更有用的东西是这样的:

–“居住在波士顿的客户有80%的概率愿意支付比不居住在波士顿的客户更多的费用”

-“住在波士顿的客户有85%的可能性愿意支付40 - 80美元”

你认为这是可以自动提取的东西吗。

不幸的是,决策树不能告诉我们任意变量的类分布。这是决策树学习方式的一个副作用。这样做的代价是你能得到更多关于子集重要的数据。

举个例子,不管一个人是否来自波士顿,他们购买你的产品的概率可能是一样的,但是,比如说,波士顿的大学生购买你的产品的概率可能要高得多。构建决策树是为了识别这些从整体数据中具有非常不同概率的子集,并且构建我们的可视化来突出这些子集中最大的一个。

我知道对于一个叶节点,你会有不止一个变量,这是非常有用的。

例:关系=丈夫和教育=单身汉和职业=教授专业和年龄>=28.72被预测为“每年超过5万美元”

但我猜一些从树下掉落的训练例子会“每年少于5万美元”。因此,当我和商业人士交谈时,我发现非常有用的是,我可以告诉他们,该部门90%的人年收入超过5万美元,10%的人收入更少。基本上我对这个预测有多有信心。

目前,可以通过评估一组从未用于训练模型的相关数据来简单地评估性能。

我们计划向节点添加额外的“可信度”信息,但是适当的不同度量也很容易被误解。我们正在讨论不同的方法来表达对分支的信心,但它超越了简单的准确性。在许多情况下,并非所有错误的预测都是同样错误或糟糕的。例如,做出错误的积极决定的成本可能会大大超过做出错误的消极决定的成本。这是机器学习价值主张的一个关键部分,所以我们要确保我们提供了对特定情况最有用的评估形式。

我完全同意你的观点,假阳性和假阴性应该有不同的代价。

我期待看到你们提出的解决方案。

祝贺你迄今为止所做的出色工作。